【新智元导读】周日,前女雇员Frances Haugen在美国60 Minutes采访上揭露Facebook用放大仇恨言论的算法谋利。为了提高用户参与度,Facebook发现最好的方式便是向用户灌输恐惧和憎恨。Facebook 数万页内部文件一夜之间尽数曝光!

告密者揭露了 Facebook 一直以来不肯承认的罪行——用「放大仇恨言论的算法」谋取利益。

这只披着羊皮的狼终现原形。

周日,告密者在美国 60 Minutes 节目上揭露了这个世界上最强大的社交媒体平台 Facebook 更多的内部运作机制。

与此同时,这位告密者也公布了自己的身份 —— Facebook前雇员Frances Haugen,并与《华尔街日报》分享了大量内部文件。

她表示,一家致力于产品优化的公司,却采用了放大仇恨言论的算法。

大量性爆炸指控都有哪些?

Facebook算法黑箱:抓住人性的弱点

此前一项数据显示,Facebook 在致力于反对仇恨言论所做的努力。

现在看来更像是一场笑话。

虽然该公司一再声称,至少在自己的产品上,它正在帮助阻止仇恨言论,但Haugen泄露的一份 Facebook内部文件表明:

「我们预计,我们的优化可能只会对Facebook上3%-5%的仇恨言论、大约0.6%的暴力和煽动内容产生作用,尽管在这一点上我们已经做到世界上做好了。」

,时长03:39

另一份文件甚至更加直白:我们从各种渠道获得的证据表明,仇恨言论、分裂性政治言论以及 Facebook 和旗下其他应用程序的错误信息正在影响世界各地的社会。

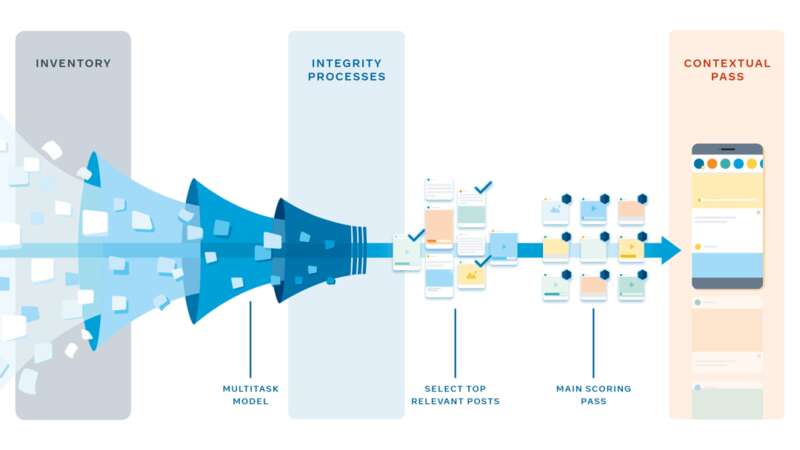

Haugen声称问题的根源在于「2018年推出的算法控制了你在平台上看到的东西」。

你用手机滑动五分钟,可能只能看到100条内容。但是 Facebook 可以向你展示成千上万种选择。

该算法根据你过去接触最多的内容类型来推送信息,通过参与度优化内容。

她表示,Facebook为了提高用户的参与度,发现最好的参与方式便是向用户灌输恐惧和憎恨。

因为激发人们的愤怒比激发其他情绪更容易。

1.6国会暴乱,Ins青少年自杀倾向,还有什么?

当时,扎克伯格称算法的改变是正面的。

「我们觉得有责任确保我们的服务不仅仅是有趣的,而且有益于人们的福祉。」

对社会负面影响案例不是没有,2018年缅甸军方利用 Facebook 发动种族灭绝,包括种族暴力。

还有2020年大选,Facebook 明白其潜在的危险,因此启动了安全系统,以减少错误信息。

但Haugen表示,许多变化都是暂时的, 选举一结束,他们就把安全系统关闭了。

但是,在选举之后,Facebook 被一些人用来组织1月6日的起义,即2021年美国国会大厦遭冲击事件。

检察官引用 Facebook 上的帖子作为证据——武装游击队员的照片和文字,包括「通过子弹或选票恢复共和国即将到来!」这样的信息。

这些极端分子使用了很多平台,但 Facebook 反复出现。

「当你消费更多内容时,Facebook 会赚更多的钱。」

Facebook编写算法的方式正在改变欧洲主要政党领导国家的方式。

Haugen获得的这份2019年的内部报告称,对算法的改变迫使他们在 Facebook上的沟通中产生负面影响,导致他们采取更加极端的政策立场。

除了Facebook,其危害也带到了 Instagram 上。

一项研究表明,13.5% 的青少年说 Instagram 让自杀的想法更糟糕; 17% 的青少年说 Instagram 让饮食失调更糟糕。

就在上周,Facebook 表示,它将推迟为更小的孩子创建 Instagram 的计划。

告密者是谁

「我在 Facebook 一次又一次地看到,对公众有利和对 Facebook 有利之间存在利益冲突。而 Facebook一次又一次地选择优化自己的利益,赚更多的钱。」

自上个月一位匿名的前雇员向联邦执法部门投诉以来,Facebook 一直急于知道告密者是谁。

此前投诉称,有证据表明,Facebook在反对仇恨、暴力和错误信息方面的问题上对公众撒了谎,但该公司一直隐瞒了它所知道的一切。

Frances Haugen今年37岁,是来自爱荷华州的数据科学家,拥有计算机工程学位和哈佛商学硕士学位。

根据一份已被删除的 LinkedIn 个人资料,Haugen 曾是 Facebook 的产品经理,被分配到 Civic Integretity 小组工作。

她在5月份辞职时偷偷拿走了一批 Facebook 研究资料,并向美国证券交易委员会泄露了一份内部研究报告,希望借此改善对该公司的监管。

她指出,自己曾在许多公司工作过,包括谷歌和 Pinterest,但在 Facebook,情况要糟糕得多,因为该公司希望将利益置于用户福祉之上。